lundi, 31 octobre 2016

« La cognition incarnée », séance 8 : La linguistique cognitive, ou quand le langage « fait corps » avec nos autres facultés

Comme à chaque lundi de cet automne, voici un bref aperçu de la prochaine séance du cours sur la cognition incarnée que je donnerai mercredi prochain à 18h au local A-1745 de l’UQAM. [les présentations en format pdf sont disponibles ici]

Comme l’indique le plan du cours, on continue à s’élever dans les niveaux d’organisation, pour aller cette semaine faire une brève incursion du côté du langage. Il ne s’agit pas de résumer ici cette vaste discipline qu’est la linguistique (j’en serais bien incapable), mais de montrer comment le courant de la cognition incarnée ne l’a pas épargnée.

Il faut d’abord se rappeler que cette discipline, en tant que partie intégrante des sciences cognitives, s’est démarquée du behaviorisme au milieu du XXe siècle. Pour Noam Chomsky par exemple, l’acquisition du langage ne peut pas être un répertoire de réponses à des stimuli, comme le soutenais le behaviorisme, puisque chaque phrase que quelqu’un produit peut être une combinaison totalement nouvelle de mots. En effet, lorsque nous parlons, nous combinons un nombre fini d’éléments, les mots, pour créer une infinité de structures plus grandes, les phrases.

Mais ces combinaisons ne se font pas au hasard. Elles dépendent de ce que l’on appelle la syntaxe, c’est-à-dire des règles et des principes qui régissent l’organisation des mots dans les phrases. La fameuse phrase de Chomsy « Colorless green ideas sleep furiously » (en français, « Les idées vertes incolores dorment furieusement. ») n’a évidemment pas de sens, mais sa syntaxe correcte nous porte à en chercher un, ce qui montre son caractère fondamental dans le langage.

Ce qu’on appelle » grammaire générative » est donc cet ensemble de règles qui nous permet de comprendre les phrases et dont nous sommes, le plus souvent, totalement inconscients. Il existerait donc une « structure profonde » du langage partagée par tous les humains, malgré la grande variabilité des langes et des règles de grammaires superficielles propres à chacune. Pour Chomsky et les autres linguistes dits » générativistes » comme lui, cette » grammaire universelle » serait innée et inscrite quelque part dans la circuiterie neuronale du cerveau humain. Les enfants qui apprennent à parler seraient donc à même de sélectionner parmi les phrases qui leur viennent à l’esprit uniquement celles qui sont conformes à cette « structure profonde » encodée dans nos circuits cérébraux, une capacité extraordinaire d’accéder au langage malgré une exposition très partielle aux variantes syntaxiques possibles (l’argument chomskyen de la » pauvreté de l’apport » qui fut à la base de sa critique décisive du behaviorisme).

On constate d’ailleurs que des enfants de quelques jours seulement sont capables de distinguer les phonèmes de toutes les langues et semblent dotés d’un dispositif inné de traitement des sons de la voix humaine.

Cela n’est pas si étonnant d’un point de vue évolutif si l’on considère la grande valeur adaptative du langage, celle permettant aux individus d’un groupe qui maîtrisent un langage de coordonner plus efficacement leur action. Considérant que la plus grande partie de l’évolution du genre humain s’est déroulée au sein de petits groupes de chasseurs-cueilleurs dans des milieux où les ressources étaient limitées, il est facile d’imaginer que les groupes qui ont le mieux coordonner leurs actions (pour la chasse, par exemple), ont mieux survécu que les autres et ont ainsi transmis leurs gènes ayant favorisé un certain câblage cérébral plus propice au langage.

Pour poursuivre avec l’évolution de la pensée de Chomsky (qui représente encore un courant important en linguistique) et des critiques qui lui ont été formulées, je reprendrai quelques extraits de la capsule sur la grammaire universelle que j’ai écrite il y a quelques années.

« Pour sa part, Chomsky ne conçoit pas l’origine de nos facultés linguistiques comme le résultat d’une quelconque pression sélective, mais plutôt comme une sorte d’accident fortuit. Cette affirmation s’appuie entre autres sur des travaux qui concluent que la récursivité, c’est-à-dire la possibilité d’enchâsser une proposition à l’intérieur d’une autre proposition (« la personne qui chantait hier avait une belle voix »), pourrait être la seule composante spécifiquement humaine du langage. Selon les auteurs de ces études, la récursivité ne serait d’abord pas apparue pour nous aider à communiquer. Elle se serait plutôt développée pour nous aider à résoudre d’autres problèmes liés par exemple à la quantification numérique ou encore aux relations sociales (répondant ainsi à la définition d’exaptation mise de l’avant par S.J. Gould). Ce ne serait qu’une fois cette capacité connectée aux autres composantes motrices et perceptuelles du langage que nous aurions eu accès à la complexité du langage humain. »

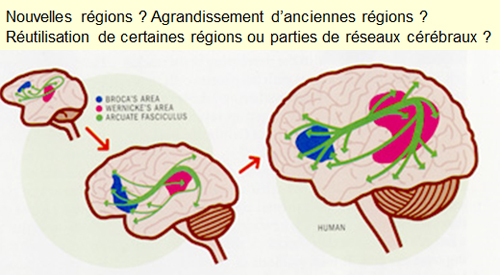

J’ajouterais ici que cette notion « d’exaptation », à laquelle on peut aussi référer en termes de « réutilisation » ou de « recyclage » neuronal, sera au cœur de la séance de la semaine prochaine.

Pour en revenir à Chomsky, dont la pensée a beaucoup évolué au fil de sa longue carrière, il en vient à travailler dans les années 1990 sur ce qu’il appelle le » programme minimaliste « .

« Autrement dit, Chomsky met moins l’accent sur quelque chose comme une grammaire universelle inscrite dans notre cerveau que sur un grand nombre de circuits cérébraux plastiques. Et avec cette plasticité viendrait un nombre infini de concepts. Notre cerveau procéderait alors à une association des sons et des concepts. Et les règles de grammaire que l’on observe ne seraient en fait que les conséquences, ou les effets secondaires de la façon dont le langage fonctionne. On peut par exemple décrire le fonctionnement d’un muscle avec des règles, mais ces règles ne font qu’expliquer ce qui arrive au niveau du muscle, pas les mécanismes utilisés par le cerveau pour générer ces règles. »

Mais même cette idée minimaliste va laisser sur leur faim plusieurs biologistes évolutionnistes.

« Ceux-ci estiment que ce n’est pas l’angle de la syntaxe qui doit être adopté pour essayer de comprendre le langage mais bien la perspective évolutive et les structures biologiques qui en sont issues. Pour Philip Lieberman par exemple, le langage n’est pas un instinct encodé dans les réseaux corticaux d’un « organe du langage » mais bien une compétence apprise qui s’appuie sur un système fonctionnel (« functional language system » en anglais) distribué dans de nombreuses structures corticales et sous-corticales.

[…] Pour Lieberman et d’autres comme Terrence Deacon, ce sont les circuits neuronaux de ce système, et non un quelconque organe du langage, qui constituent un ensemble prédéterminé génétiquement limitant les caractéristiques possibles d’un langage. En d’autres termes, nos ancêtres auraient inventé des modes de communication compatibles avec les habiletés naturelles du cerveau. Et les contraintes inhérentes à ces habiletés naturelles se traduiraient ensuite concrètement par des structures universelles du langage. »

Cette conception des choses n’est d’ailleurs pas sans évoquer ce que dit par exemple Stanislas Dehaene au sujet de nos systèmes d’écriture. Ceux-ci se seraient développés dans la forme qu’on leur connait (de petits traits foncés avec de nombreux angles et intersections) en prenant parti des prédispositions de notre système visuel pour la détection de tels angles et intersections dans les paysages naturels. Ce ne serait donc pas notre cerveau qui aurait subi des adaptations pour la lecture (il n’en aurait pas eu le temps, celle-ci n’étant apparue qu’il n’y a que 5 ou 6 000 ans), mais bien cette invention culturelle qui se serait adaptée aux contraintes de notre cerveau.

Parlant de Dehaene, je m’en voudrais de ne pas vous signaler les sept excellents cours qu’il a donnés l’hiver dernier sur le langage et ses bases cérébrales, cours que l’on peut visionner gratuitement sur le site du Collège de France.

Mais pour en revenir à cette idée qu’il y aurait quelque chose de qualitativement différent avec le langage qui demeurerait séparé des autres processus cognitifs, elle avait déjà été critiquée dès les années 1970 par des gens comme George Lakoff.

« Contrairement à Chomsky pour qui la syntaxe est indépendante de la signification, du contexte, des connaissances, de la mémoire, etc., Lakoff montre que la sémantique, le contexte ou d’autres facteurs peuvent entrer en ligne de compte dans les règles qui gouvernent la syntaxe. La métaphore, autrefois vue comme une simple construction linguistique, devient aussi avec Lakoff une construction conceptuelle essentielle et centrale dans le développement de la pensée. »

Ce sont de telles idées, en réaction aux approches chomskyennes jugées trop formelles, qui vont constituer le fondement de ce qu’on appelle aujourd’hui la linguistique cognitive. Celle-ci a un engagement clair en faveur d’une approche multidisciplinaire pour la compréhension du langage, cherchant à intégrer ce que nous savons sur la cognition humaine grâce aux autres disciplines des sciences cognitives : la psychologie, la philosophie, l’intelligence artificielle, mais peut-être plus que tout, les neurosciences.

Un exemple des efforts d’intégration des données des neurosciences pour comprendre le langage est par exemple le « modèle déclaratif / procédural du langage » défendu par exemple par Michael Ullman. Ce travail d’Ullman, que nous aurons l’occasion de détailler dans la seconde partie de la séance de cette semaine, se base sur le fait que pour parler, on a besoin de notre mémoire. En effet, tant notre lexique que nos règles de grammaire doivent être appris, peu importe notre langue maternelle. Se pourrait-il alors que des structures cérébrales, bien connues pour jouer un rôle important dans certains systèmes de la mémoire humaine, soit fortement impliquées dans le langage ?

Poser la question, c’est y répondre, comme dirait l’autre… Car effectivement, on a très vite constaté que la mémoire déclarative (associée entre autres à l’hippocampe) est grandement impliquée au niveau de l’apprentissage du vocabulaire d’une langue, alors que la mémoire procédurale (associée à des structures cérébrales comme les ganglions de la base) participe à l’apprentissage des règles de grammaire. On voit donc se dessiner ici encore assez clairement deux exemples de « recyclage neuronal ». D’une part, une réutilisation des capacités mnésiques de la mémoire déclarative, capable d’apprendre rapidement des items ou des événements isolés, pour se mettre au service de l’apprentissage du lexique (également des items isolés). Et d’autre part la mémoire procédurale, capable de retenir des séquences de mouvement dans le cadre d’une tâche motrice complexe, qui se met au service de la grammaire pour en retenir les règles séquentielles complexes.

Voilà donc qui constitue aussi, je l’ai déjà mentionné, un bon lien vers la séance prochaine autour de ce concept de réutilisation neuronale.

De la pensée au langage | Comments Closed