lundi, 5 septembre 2016

« La cognition incarnée », séance 1 : Survol historique des sciences cognitives et présentation du cours

Comme promis il y a deux semaines, voici donc un bref aperçu du premier cours sur la « cognition incarnée » que je donnerai mercredi à 18h au local A-1745 du pavillon Hubert-Aquin de l’UQAM. Et comme je l’indiquais dans le plan de cours présenté la semaine dernière, cette première séance consistera en un survol historique des grands paradigmes qui se sont succédé en sciences cognitives depuis un siècle. [le pdf de la présentation Power Point de cette séance est disponible ici]

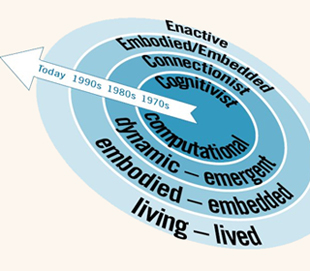

Car avant d’en arriver à l’idée générale du cours qui est de regarder comment notre cerveau, notre corps et l’environnement dans lequel nous nous trouvons interagissent constamment pour produire ce qu’on appelle la cognition (c’est-à-dire les processus produidant des connaissances au sens large), il faut prendre conscience qu’on est parti de très loin avant d’en arriver à ce constat que les sciences cognitives font aujourd’hui.

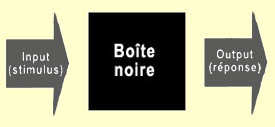

Du behaviorisme, par exemple. Dominant à partir des années 1920, il s’agissait d’aller au-delà des méthodes introspectives du siècle précédent jugées peu scientifiques et trop aléatoires. Les Watson et Skinner ont donc décrété que le cerveau était une boîte noire scientifiquement inaccessible, mais que l’on pouvait regarder les inputs sensoriels et les outputs comportementaux et en déduire des lois. Les travaux de Pavlov sur le conditionnement classique sont un exemple… classique de résultats produits sous ce paradigme.

Le terme paradigme, introduit par Thomas Kuhn, réfère à la théorie dominante d’un domaine de recherche à une époque donnée. Pour Kuhn, ce paradigme change lorsqu’un certain nombre de données non explicables par la théorie s’accumulent et finissent par la fragiliser. C’est à ce moment qu’un autre paradigme peut le détrôner en montrant comme il peut, lui, expliquer ces données anormales.

Et c’est ce qui s’est passé dans les années 1950 par l’entremise de la linguistique, entre autres. Le linguiste Noam Chomsky va ainsi affirmer que « vouloir étendre le modèle béhavioriste de l’apprentissage à la linguistique est sans espoir. » Pour lui, nos compétences linguistiques ne peuvent être expliquées sans admettre que les êtres humains possèdent un répertoire important de structures cognitives complexes qui président à l’usage du langage.

En 1956, le psychologue George Miller avait aussi publié le célèbre article « The magical number seven, plus or minus two: Some limits on our capacity for processing information », où il attirait l’attention sur certaines capacités limitées de la mémoire humaine, impliquant donc qu’on pouvait chercher à comprendre les mécanismes derrière cette limitation.

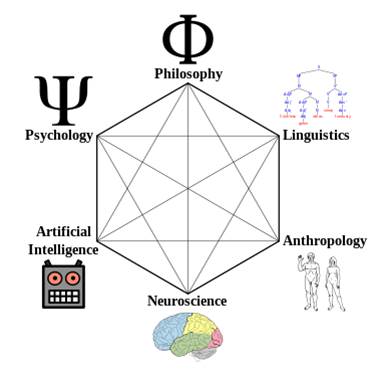

Bref, au tournant des années 1960 il devint clair qu’un nouveau paradigme, finalement appelé « sciences cognitives » avait vu le jour, et qu’il était par la pluralité des disciplines qui l’avaient élaboré, foncièrement transdisciplinaire.

Sur les six disciplines reconnues comme fondatrices des sciences cognitives, Miller considérait que la psychologie, la linguistique et l’informatique étaient centrales alors que les autres jouaient un rôle plus périphérique. Et l’on va voir que ce sont probablement les neurosciences qui, aujourd’hui, pourraient revendiquer ce rôle central.

Mais si l’on revient au début des sciences cognitives, il faut comprendre que le paradigme qui s’est alors constitué sous l’influence des trois disciplines dominantes mentionnées, et que l’on appelle à juste titre « cognitivisme » (ou symbolisme, ou encore computationnalisme), va remplacer la boîte noire des behavioristes par du « traitement de l’information ». Autrement dit, on garde les inputs et les outputs, mais entre les deux, on va se faire des représentations du monde extérieur. Et en transformant ces représentations selon certaines règles, donc en manipulant de l’information symbolique, on va trouver des solutions aux problèmes que l’on va transmettre à nos muscles considérés comme de simples effecteurs pour actualiser la solution trouvée.

C’est, pour aller vite, « le modèle en sandwich de la cognition » tel que formulé par Susan Hurley et qui ne diffère pas vraiment du bon vieux modèle cartésien. Et c’est de ce modèle, je vous lâche tout de suite le scoop (!), que les tenants d’une conception incarnée de la cognition vont vouloir se libérer. Mais n’allons pas trop vite et apprécions un peu cette trentaine d’années où le paradigme cognitiviste va régner en maître. « It’s the only game in town ! », répondait Jerry Fodor quand on le questionnait sur des alternatives à ce modèle…

Il faut dire que cette façon d’appréhender l’esprit humain était pour le moins bien appuyé par une technologie de pointe qui se développait durant les mêmes décennies : l’ordinateur. De tout temps, les technologies de pointe ont servi de métaphore au fonctionnement du cerveau (les pompes et les fontaines de la Grèce Antique, les engrenages et les ressorts des horloges du siècle des Lumières, les panneaux de contrôle avec fils des téléphonistes, etc.), mais la distinction entre « software » et « hardware » des ordinateurs semblait tellement tomber sous le sens qu’elle fut LA référence du cognitivisme (et même encore aujourd’hui, la métaphore automatique du cerveau de bien des gens).

Les neurones seraient donc le « hardware » et nos processus de pensée le « software » roulant, pour employer le terme des informaticiens, sur ce substrat physique particulier. D’où l’idée que le substrat neuronal importait peu, au fond, pour comprendre la pensée puisque comme votre Word peut rouler autant sur un PC que sur un Mac, les facultés mentales particulières de l’être humain pouvaient faire fi de l’organisation du cerveau en vertu de cette thèse fonctionnaliste dite de la « réalisation multiple ». En d’autres termes, tout résidait dans la computation du software.

Et c’est là où (autre petit flash-forward…), les tenants de la cognition incarnée ne seront, mais alors là pas du tout, d’accord ! Le type de computation que font nos neurones n’est pas entièrement de nature digitale (comme l’ordinateur), ni de nature analogique, mais d’un autre type qui a des composantes digitales et analogiques. Et pour l’approche incarnée de la cognition, ce genre de « petit détail » doit être pris en compte dans les modèles computationnels de l’esprit. Tout comme le fait, comme on le verra, que le cerveau est loin d’être la machine passive qui attend ses inputs pour les traiter tel que le conçoit le cognitivisme, mais possède une activité endogène incessante qui ne sera pas « informée » par le monde extérieur mais plutôt « perturbée » par lui. Ou encore, pour le dire comme les gens qui voient le cerveau comme une machine à faire des prédictions (« predictive coding », que l’on présentera à la dernière séance), l’environnement ne fait qu’informer les modèles cérébraux du monde des erreurs qu’ils ont faites par rapport à ce qui s’y passe réellement.

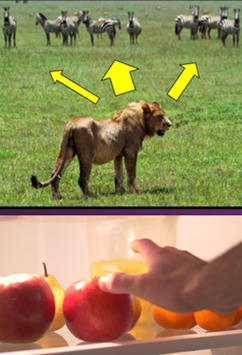

Bon, là je me rends compte que je vais un peu vite et que c’est loin d’être facile de résumer chronologiquement en quelques pages une histoire aussi riche et complexe. D’autant plus que si je suis un peu mon Power Point, j’en arrive aux années 1970 où je vais dire un mot des neurosciences qui commencent véritablement à prendre leur essor et de travaux fondateurs en biologie théorique, notamment ceux de Maturana et Varela sur l’autopoïèse. Mais comme j’en ai parlé ailleurs (suivez les liens précédents…), je vais me restreindre à une dernière digression du côté des travaux sur la perception visuelle de James Gibson qui va mettre l’emphase sur ce qu’il va nommer les “affordances”, c’est-à-dire les possibilités d’action que suggèrent à un organisme donné tel ou tel objet ou aspect de son environnement.

Cette approche « écologique » va commencer à remettre en question le cognitivisme et tout le traitement symbolique abstrait qui vient avec. L’aphorisme de Gibson « Ask not what’s inside your head, but what your head’s inside of » renvoie à l’importance qu’il accorde à l’environnement et préfigure plusieurs modèles actuels de la cognition qui intègre la notion d’affordance (notamment les travaux de Paul Cisek que nous allons explorer à la séance 11).

Revenons donc à ce qu’on pourrait appeler la ligne principale des différentes « vagues » ou grands paradigmes des sciences cognitives avec ce qu’on a appelé, dans les années 1980, le connexionnisme. Car le cognitivisme a montré ses limites, notamment avec des critiques comme celle de la chambre chinoise de John Searle qui a mis en évidence le problème de l’ancrage du sens des symboles dans le monde réel. On n’a pas le temps d’épiloguer là-dessus ici, mais disons que, pour aller vite, on s’est aperçu que si les architectures cognitivistes (ce concept sera explicité et exploré à la séance 7) ne réussissaient bien que dans des tâches circonscrites et locales (par exemple jouer aux échecs), c’était peut-être parce qu’elles essayaient de reproduire l’intelligence d’un expert adulte. Or une conviction s’est alors développée que la forme d’intelligence la plus fondamentale n’est peut-être pas celle de l’expert, mais bien celle d’un… bébé !

Car un bébé peut acquérir le langage et constituer des objets signifiants à partir de ce qui semble être une masse informe de stimuli. Il fallait donc chercher plutôt à simuler l’intelligence du bébé qui apprend.

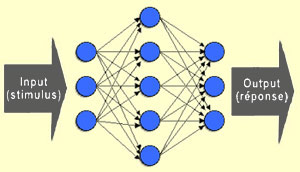

Ce qu’on va appler le connexionnisme va également se rapprocher de la structure du cerveau et de ses réseaux de neurones en concevant ses architectures de façon similaire, c’est-à-dire avec d’innombrables éléments simples reliés par des connexions dont l’efficacité peut varier. La cognition devient ainsi plus une affaire d’entraînement que de programmation et elle va pouvoir émerger d’états globaux dans un réseau de composants simples.

Dans les années 1990, le connexionnisme va à son tour recevoir des critiques, principalement de ceux et celles qui pensent qu’on ne peut comprendre réellement ce qu’est la cognition en faisant fi du corps où se trouve le cerveau, comme le faisaient encore les modèles connexionnistes avec leurs inputs et leurs outputs désincarnés (en cela, comme le cognitivisme avant lui).

Des gens comme Francisco Varela ne vont pas nier tous les apports du cognitivisme et du connexionnisme mais ils les jugent insuffisants. Par exemple, la manipulation symbolique du cognitivisme n’est pas complètement rejetée par Varela, mais vue plutôt comme une description de niveau supérieur de propriétés qui se trouvent concrètement matérialisées dans un système distribué et interconnecté sous-jacent. Toujours pour Varela, les réseaux de neurones connexionnistes peuvent donc servir à décrire adéquatement la cognition, mais à condition qu’il puisse produire de la signification.

Et pour qu’un tel réseau puisse produire de la signification, il doit non seulement être sensible aux variations de son environnement et agir en conséquence pour rester en vie, mais il doit pour ce faire nécessairement posséder une histoire qui s’inscrit dans le corps et le cerveau de l’organisme. Car au fond, ce qu’on observe concrètement à chaque jour, c’est ça : des agents incarnés qui sont mis en situation d’agir et donc entièrement immergés dans leur perspective particulière face à tel ou tel environnement.

L’approche énactive que vont proposer Varela, Thompson et Rosch en 1991 dans leur ouvrage « The Embodied Mind. Cognitive Science and Human Experience » cherche ainsi à faire le pont entre les approches incarnées et dynamiques de la cognition (l’aspect dynamique sera abordé à la séance 5) et les approches phénoménologiques de la subjectivité et de l’expérience humaine.

Puis, dans les années 2000, différentes approches dites “radicales” de la cognition incarnée vont voir le jour (et nous en donneront un aperçu à la séance 13). Ici, non seulement le cerveau n’est pas la seule ressource disponible pour résoudre les problèmes, mais c’est notre corps entier avec ses actions perceptuellement guidées dans le monde qui fait le gros du travail, remplaçant ainsi la nécessité de représentations mentales complexes.

Mais tout n’est pas si simple car même les défenseurs les plus optimistes de ces explications non représentationnelles admettent que certains phénomènes mentaux appellent presque naturellement une explication en terme de représentation, le langage étant toujours un peu le caillou dans le soulier de ces gens-là… Il est possible cependant, comme le soutiennent par exemple les tenants d’une approche probabiliste du « cerveau prédictif » (abordé à la dernière séance), que durant l’hominisation on soit passé progressivement vers de plus en plus d’abstraction et de représentation tout en conservant des processus incarnés déjà présents.

C’est le genre de question que nous nous poserons tout au long de ce cours. Des heures de plaisir en perspective… 😉

Je vous invite donc à nous suivre la semaine prochaine pour le véritable début du périple. Cette fois-ci, je ne me donnerai pas comme mission un peu folle de résumer un siècle de sciences cognitives en 3 pages (ou en 3 heures mercredi). Non, non, non. Seulement 13,7 milliards d’années d’évolution cosmique dont 3,8 d’évolution biologique en une petite heure et demie ! ;-P (car on aura un texte à discuter dans la 2e moitié du cours)

Non classé | Comments Closed