mardi, 28 janvier 2020

Un « concours » pour tester deux grandes théories rivales sur la conscience

Ce n’est pas ce qu’on pourrait appeler la façon classique de faire de la science. Mais quand vient le temps d’étudier quelque chose d’aussi complexe et évanescent que la conscience humaine, il semble qu’on puisse en arriver à l’étonnant « concours » dont j’aimerais vous parler aujourd’hui. Deux grandes théories rivales sur les corrélats neuronaux de la conscience vont en effet être testées littéralement l’une contre l’autre dans six laboratoires répartis sur trois continents ! C’est ce que nous apprenait un article de la revue Science en octobre dernier, tout en précisant que ce qui ressemblait à une sorte de pari fait entre scientifiques à la pause-café était tout de même assorti d’un budget de 20 millions de dollars venant d’une fondation subventionnant les recherches à l’intersection de la science et de la religion.

Ce n’est pas ce qu’on pourrait appeler la façon classique de faire de la science. Mais quand vient le temps d’étudier quelque chose d’aussi complexe et évanescent que la conscience humaine, il semble qu’on puisse en arriver à l’étonnant « concours » dont j’aimerais vous parler aujourd’hui. Deux grandes théories rivales sur les corrélats neuronaux de la conscience vont en effet être testées littéralement l’une contre l’autre dans six laboratoires répartis sur trois continents ! C’est ce que nous apprenait un article de la revue Science en octobre dernier, tout en précisant que ce qui ressemblait à une sorte de pari fait entre scientifiques à la pause-café était tout de même assorti d’un budget de 20 millions de dollars venant d’une fondation subventionnant les recherches à l’intersection de la science et de la religion.

La question des rapports qu’entretient le cerveau avec la conscience nourrit des débats passionnés depuis que certains neuroscientifiques osent aborder cette question de front, en gros depuis le début des années 1990. D’où les innombrables modèles et théories qui s’affrontent depuis des années. Mais si certaines données empiriques sont parfois bien expliquées par telle ou telle théorie, il en est deux qui, par le grand cadre général qu’elles proposent, se sont démarquées du lot et sont devenues des paradigmes incontournables dans le domaine.

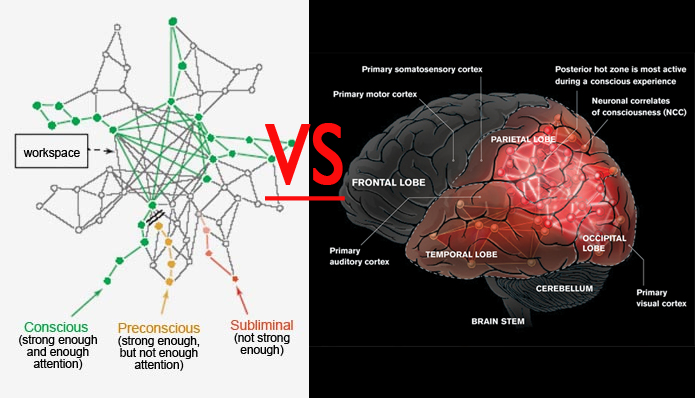

La première théorie est celle de l’espace de travail global (« global workspace theory, ou GWT », en anglais), proposée par le psychologue Bernard Baars et étayée par les neurobiologistes Stanislas Dehaene et Jean-Pierre Changeux. Elle part d’une idée qui remonte aux premiers temps de l’intelligence artificielle selon laquelle des données rendues accessibles à un endroit du système (un « tableau noir » ou « blackboard », pour reprendre la métaphore habituelle) vont permettre à de nombreux modules spécialisés d’être mis au courant de ces informations et de les utiliser. Et pour aller très vite, ce serait cette diffusion (ou « broadcast ») aux multiples sous-systèmes cognitifs de notre cerveau (attention, mémoire de travail, planification, etc.) qui nous ferait percevoir cette étrange impression subjective qu’on appelle la conscience.

Pour la GWT, le cortex frontal est une région cruciale parce que fortement impliqué dans la sélection de l’information sensorielle à retransmettre aux autres régions qui exécuteront les processus cognitifs ou les actions appropriées. De plus, pour Dehaene et ses collègues, les ordinateurs actuels n’atteignent pas encore notre niveau de sophistication cognitive, mais ils ne voient pas pourquoi les ordinateurs du futur ne l’atteindraient pas pour devenir conscient eux aussi.

La théorie de l’information intégrée (« integrated information theory, ou IIT »), proposée par Giulio Tononi et adoptée par plusieurs autres neurobiologistes comme Christof Koch, est la théorie rivale de la GWT. Pour elle, le niveau de conscience d’un système (un cerveau par exemple) est relié aux interconnexions que l’on retrouve dans ce réseau particulier. Plus nombreux seront les neurones à interagir les uns avec les autres, plus l’organisme aura une expérience consciente unifiée, et ce, même sans input sensoriel immédiat. Encore une fois très grossièrement, Tononi postule que tout système complexe interconnecté par des relations causales va nécessairement ressentir « l’effet que ça fait » d’être ce système. Autrement dit, il aura un certain niveau de conscience qui dépendra de sa complexité et du niveau d’intégration dont il est capable.

Là où ça devient pas mal flyé, si vous me permettez l’expression, c’est que pour l’IIT, la conscience étant la puissance causale intrinsèque d’un système complexe (comme le cerveau humain), on peut en dériver une valeur appelée Φ (prononcez “fi”) capable de quantifier le niveau de conscience de ce système. Si Φ est égal à 0, le système ne ressentirait rien. Mais plus la valeur de Φ augmente, plus le système serait conscient.

Le cortex humain éveillé avec une connectivité très spécifique et extrêmement riche produit une grande valeur de Φ et donc un haut niveau de conscience. Mais pas le cervelet humain qui, malgré son nombre astronomique de neurones, contribue très peu à la conscience (et l’on sait qu’il peut être beaucoup endommagé sans l’affecter). C’est aussi cette valeur de Φ que la technique « zap-and-zip » permet de mesurer (voir le p.s. à la fin de ce billet).

L’IIT prédit aussi que toute simulation, même très sophistiquée, d’un cerveau humain sur un ordinateur ne peut pas être consciente, de la même manière qu’une simulation de l’attraction gravitationnelle d’un trou noir ne déformera pas l’espace-temps autour de l’ordinateur qui exécute ces calculs. Pour l’IIT, la conscience ne peut pas être « computée », elle doit être construite dans la structure même du système.

Dernier détail mais non le moindre pour revenir à notre concours, les tenants de l’IIT suspectent que le gros du travail est fait une vaste zone de la partie postérieure du cerveau incluant le cortex pariétal, occipital et temporal. Contrairement à la GWT, le cortex frontal ne serait que très peu impliqué. Des protocoles expérimentaux, où des sujets deviennent par exemple conscients de l’apparition d’une image à mesure que sa présentation devient suffisamment longue, seront donc mis en oeuvre pendant que l’on scannera le cerveau des sujets avec différents appareils d’imagerie cérébrale (résonnance magnétique fonctionnelle, électroencéphalographie, électrocorticographie). Si l’activation correspondant à la prise de conscience du stimulus est d’abord frontale, cela plaidera fortement en faveur de la GWT. Par contre, si elle survient surtout dans la partie postérieure du cerveau, c’est l’IIT qui marquera des points.

Tononi et Dehaene se sont mis d’accord sur les paramètres des expériences et on préenregistré leur prédiction pour chacune d’elles. Et pour éviter tout conflit d’intérêt, aucun des deux ne collectera ou n’interprétera les données. Ce que rend l’issu de la démarche assez excitante, c’est que chacun a accepté, si les résultats semblent falsifier leur théorie, d’admettre qu’ils avaient tort. Du moins en partie, car rien n’est jamais simple en science, et encore moins avec la conscience…

* * *

P.s. : La technique « zap-and-zip », qui fut développée par Giulio Tononi au début des années 2000, utilise la stimulation magnétique transcrânienne qui permet de « zapper » (d’activer ou d’inactiver) certaines petites régions du cerveau en appliquant un bref champ magnétique à la surface du crâne. L’activité électrique des neurones affectés est donc perturbée, et ces perturbations se répercutent de neurones en neurones ailleurs dans le cortex jusqu’à ce que le signal s’amenuise et finisse par arrêter. C’est cette réverbération plus ou moins étendue dans l’espace et dans le temps que l’on peut mesurer avec un appareil à électroencéphalogramme (EEG). Ce que l’on observe alors, c’est que plus le signal recueilli est prévisible, moins le cerveau est conscient. J’avais déjà exposé ce phénomène pour l’état de veille, de sommeil profond et de sommeil paradoxal dans un billet antérieur, sans toutefois nommer explicitement la technique « zap-and-zip » alors utilisée.

Pour en venir à la partie « zip » de la technique maintenant, l’analogie qui permet de la comprendre est celle de la compression d’un fichier informatique pour le rendre plus léger (dans le format .zip, par exemple). Comme pour un fichier, plus le déroulement d’une réverbération est prévisible, plus elle pourra être compressée facilement. Au contraire, quelque chose de complexe est plus difficile à compresser. La technique « zap-and-zip » a ainsi pu établir que des sujets éveillés ont un “perturbational complexity index” entre 0,31 et 0,70 et une personne anesthésiée ou endormie en bas de 0,31. On l’a aussi testée sur des patients minimalement conscients ou dans des états végétatifs où elle a permis de confirmer les diagnostics, mais aussi d’identifier un certain nombre de cas où, bien que diagnostiqués dans un état végétatifs, le “perturbational complexity index” se situait plutôt dans la fenêtre des valeurs conscientes, sous-entendant que ces personnes étaient peut-être conscientes mais incapables de communiquer.

Au coeur de la mémoire | Comments Closed