mardi, 26 septembre 2017

Trois découvertes des années 1950 à la base des neurosciences computationnelles

Comme je l’ai présenté ici le 11 septembre dernier, voici quelques éléments de mon cours #2 de l’université du troisième âge (UTA) donné hier à St-Bruno et demain à Longueuil.

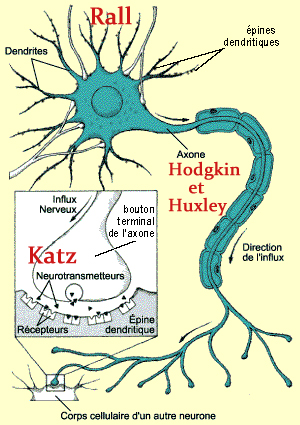

Je voudrais vous parler cette semaine de l’importance de la décennie 1950 dans notre compréhension des mécanismes de base de la communication neuronale. Cela m’a sauté aux yeux en rapportant les travaux de trois pionniers des neurosciences qui, comme les trois mousquetaires, étaient en fait quatre ! D’abord le duo Alan Hodgkin et Andrey Huxley (prix Nobel 1963) qui ont élucidé les bases de la conduction nerveuse; puis les travaux de Bernard Katz (prix Nobel 1970) sur le relâchement des neurotransmetteurs au niveau de la synapse; et finalement l’apport de Wilfrid Rall sur la diffusion des potentiels excitateurs et inhibiteurs à travers les dendrites jusqu’au corps cellulaire du neurone.

À eux trois (ou plutôt à eux quatre…), ils ont jeté les bases de ce qu’on allait appeler dans les années 1980 les neurosciences computationnelles, c’est-à-dire comment les neurones font pour s’échanger de l’information et faire des calculs. Donnons en quelques mots une idée de chacune de leur contribution (vous trouverez évidemment plus de détails dans ma présentation).

Dès le début des années 1950, Hodgkin et Huxley ont réussi à enregistrer avec des microélectrodes dans les axones géants des neurones de calmar. En injectant du courant électrique dans l’axone et en enregistrant sa réponse électrique, ils ont élaboré un modèle mathématique de la conduction de l’influx nerveux. Parmi les données empiriques et les faits connus à l’époque qui les ont aidés dans l’élaboration de leur modèle, on note :

– Les neurones baignent dans du liquides physiologiques;

– De nombreuses substances se dissocient en ions chargés dans ce liquide (Ex.: NaCl en Na+ et Cl-);

– Ces particules chargées ne se répartissent pas également à l’intérieur et à l’extérieur du neurone : l’intérieur est environ 70 millivolts plus négatif que l’extérieur;

– Les neurones ont une membrane semi-perméable qui vont permettre le passage sélectifs de certains ions à travers elle, générant ainsi l’influx nerveux;

Hodgkin et Huxley avaient ainsi saisi plusieurs propriétés des protéines-canaux qui génèrent les potentiels d’action bien avant leur caractérisation. En effet, ce n’est que plus tard qu’on démontrera que les pores de cette membrane semi-perméable sont des protéines transmembranaires avec en leur centre un canal sélectif à certains ions. Et que ces protéines-canaux, peuvent changer de conformation (i.e. s’ouvrir ou se fermer) en fonction du potentiel de membrane autour d’eux.

À la même époque, Katz travaillait quant à lui sur la jonction neuromusculaire de la grenouille. Il avait noté, lui aussi en enregistrant dans le muscle avec des microélectrodes, la présence évidente de potentiels excitateurs en réponse à un influx nerveux qui arrivait au bout de l’axone du nerf moteur. Mais il avait surtout observé des « mini-potentiels » excitateur qui survenaient spontanément dans le muscle sans même qu’il y ait d’influx nerveux dans l’axone du nerf moteur. Et comme ces mini-potentiels avaient tous à peu près la même amplitude, Katz en a déduit qu’ils devaient constituer des « quantités de base » de neurotransmetteurs émis spontanément par l’axone du neurone moteur.

Et c’est ainsi que les vésicules synaptiques contenant les neurotransmetteurs ont été mises en évidence. On comprend aujourd’hui beaucoup mieux comment ces vésicules fusionnent avec la membrane de l’axone pour libérer les neurotransmetteurs dans la fente synaptique, comment le calcium qui entre dans le bouton terminal de l’axone avec l’arrivée de l’influx nerveux aide à mobiliser ces vésicules, etc.

Finalement, c’est vers la fin des années 1950 qu’on a compris comment calculer les courants électriques qui diffusent passivement dans les dendrites grâce à la « théorie des câbles » de Wilfrid Rall. Le problème était de comprendre comment se propagent toutes les excitations et les inhibitions reçues sur les dendrites d’un neurone jusqu’au début de l’axone (ou « zone gâchette ») où des canaux membranaires différents vont déclencher le phénomène « tout ou rien » du potentiel d’action si la somme des excitations réussit à dépolariser la membrane au-delà d’un certain seuil.

Le problème, c’est que l’arbre dendritique du moindre neurone est extrêmement complexe, ressemblant aux branches d’un arbre avec des diamètres de plus en plus petits à mesure qu’on s’éloigne du corps cellulaire. Rall va réussir à estimer comment va varier la diffusion des excitations et des inhibitions le long de ces branches dendritiques au diamètre variable en les modélisant comme des cylindres de différents diamètres avec, pour chaque petit bout de cylindre, une résistance (due au cytoplasme) et une capacitance associée (due à la membrane).

Et c’est comme ça qu’on a pu comprendre un peu mieux comment les signaux que reçoit constamment un neurone, souvent de milliers d’autres neurones, sont intégrés afin de déterminer si le neurone enverra à ce moment précis un influx nerveux au neurone suivant. Et je vous laisse avec cette citation d’un article de Dharmendra Modha et ses collègues qui résume fort bien le caractère étonnant de tout cela :

« Le fait qu’une cellule vivante se soit adaptée en une structure capable de recevoir et d’intégrer des données, de prendre des décisions fondées sur ces données, et d’envoyer des signaux aux autres cellules en fonction du résultat de cette intégration est un exploit remarquable de l’évolution. »

* * *

Je suis tombé sur cet article de Cade Metz du New York Times ce matin qui résonne aussi particulièrement bien avec un autre aspect de ce cours #2. J’aborde en effet vers la fin les différences entre cerveau et ordinateur en précisant cependant que l’intelligence artificielle a fait de grands bonds ces dernières années avec le « deep learning » en s’inspirant des réseaux de neurones du cerveau. Et bien il semblerait que les composantes mêmes du « hardware » des ordinateurs est en train d’être modifié par une conception des choses qui se rapproche en fait des capacités computationnelles distinctes de différentes régions cérébrales découlant de son organisation cytoarchitecturale. C’est un peu « garroché » vite de même, mais si vous voulez avoir un énième exemple où la technologie s’inspire de quelque chose que la nature a déjà conçu, vous pouvez lire ce résumé ou l’article en question.

Du simple au complexe | Comments Closed