lundi, 17 octobre 2016

« La cognition incarnée », séance 7 : Architectures cognitives modulaires et duales : la quête de la plausibilité biologique

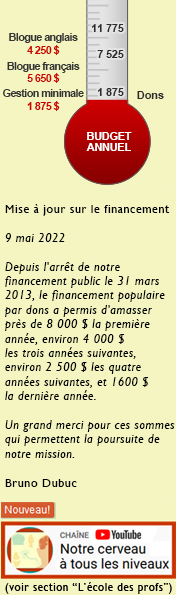

Comme à chaque lundi de cet automne, voici un bref aperçu de la prochaine séance du cours sur la cognition incarnée que je donnerai mercredi prochain à 18h au local A-1745 de l’UQAM. [les présentations en format pdf sont disponibles ici]

Comme l’indique le plan du cours, on continue à s’élever dans les niveaux d’organisation, pour aller cette semaine vers des modèles plus théoriques et philosophiques de la cognition incarnée.

On se souviendra de notre petit survol introductif de l’histoire des sciences cognitives de la première séance que l’approche dominante des années 1960 à 1980, le cognitivisme, voulait simuler les performances d’un expert humain adulte. Mais comme celui-ci ne réussissait bien à résoudre que des tâches assez circonscrites et locales (par exemple, jouer aux échecs), un doute s’est installé : et si la forme d’intelligence la plus fondamentale n’était pas celle de l’expert adulte, mais bien celle d’un… bébé ?

Car un bébé peut acquérir le langage et constituer des objets signifiants à partir de ce qui semble être une masse informe de stimuli. Il fallait donc chercher plutôt à simuler l’intelligence du bébé qui apprend.

Et c’est ce qu’a fait le connexionnisme à partir du début des années 1980 en prenant en compte également davantage le substrat biologique de la cognition : les réseaux de neurones du cerveau humain. La cognition était maintenant vue comme émergeant d’états globaux dans un réseau de composantes simples mais richement interconnectées. Et elle était aussi plus une affaire d’entraînement que de programmation.

Mais le connexionnisme amenait un peu toutes les tâches cognitives à être vues comme des tâches de perception ou de catégorisations, ce en quoi cette approche excellait. Alors on s’est mis à essayer de construire des « architectures cognitives » complètes du cerveau tout en continuant de tenir compte de la plausibilité biologique de ses composantes.

Ce qu’on appelle une architecture cognitive est donc un modèle computationnel dont la structure est partiellement ou complètement inspirée des systèmes cognitifs naturels des animaux (incluant les humains). C’est l’idée d’un système global unique comprenant un ensemble de mécanismes travaillant de concert pour réaliser la grande variété des comportements cognitifs humains (résolution de problème, prise de décisions, gestes automatisés, mémoire, apprentissage, etc.).

Certaines de ces approches sont fortement symboliques au sens où elles sont encore influencées par l’idée centrale du cognitivisme, à savoir que l’esprit est une machine manipulant des ensembles complexes de symboles à l’aide du raisonnement logique. En manipulant des symboles avec des règles souvent organisées hiérarchiquement en différents modules, on parvient à accomplir certaines tâches comme le montrent les architectures SOAR ou ACT-R, deux exemples bien développés de ce type d’approche.

Mais cela demeure bien désincarné car les contraintes biologiques que l’on s’impose dans ces modèles sont très faibles. La plausibilité biologique s’élève d’un cran, comme on l’a dit, avec les architectures fortement connexionnistes car elles sont directement inspirée du fonctionnement neuronal: le raisonnement ne se fait pas grâce à la syntaxe et des règles d’inférence mais par la transformation de patrons d’activité entre les éléments du système. C’est le cas du modèle LEABRA, l’un des plus connus dans cette catégorie.

Il y a maintenant aussi des approches hybrides des deux précédentes catégories (SPA et CLARION en sont des exemples). On combine ici des propriétés du symbolisme et du connexionnisme, mais cela brise, d’une certaine façon, l’unité structurelle de l’architecture. En revanche, on va chercher ainsi « le meilleur des deux mondes », comme l’ont fait Chris Eliasmith et ses collègues avec leur « Large-Scale Model of the Functioning Brain » publié dans la revue Science en novembre 2012.

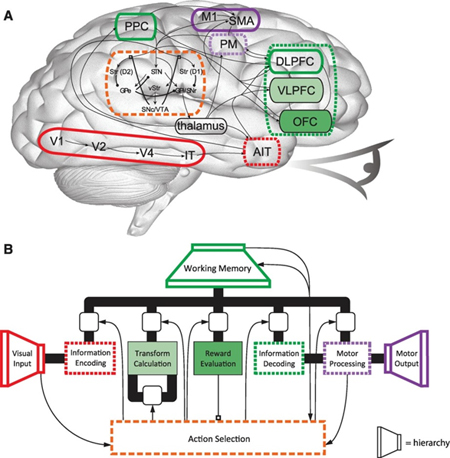

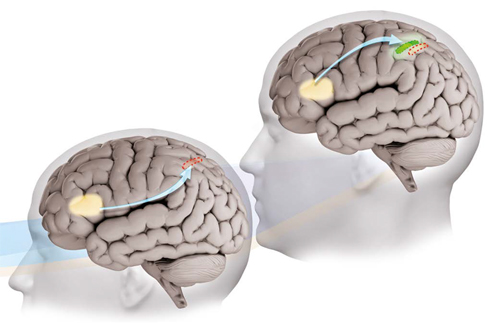

Ce modèle « à large échelle » (donc qui délaisse forcément beaucoup de détails dans la connectivité fine des neurones) est tout de même fort intéressant d’un point de vue de la plausibilité biologique. Il possède tout d’abord une caméra qui agit comme système sensoriel (voir l’image en haut de ce billet) ce qui lui confère déjà un avantage « incarné » sur beaucoup de modèles antérieurs où c’était encore une personne de l’extérieur qui rentrait les données à analyser en les tapant sur un clavier d’ordinateur… Le modèle possède aussi une hiérarchie de compression connexionniste à l’entrée et à la sortie qui extrait les caractéristiques les plus importantes des stimuli (il y a donc perte d’information en conceptualisant, mais cela permet de travailler plus facilement par la suite). Le modèle s’inspire aussi d’une architecture anatomo-fonctionnelle du cerveau appelée « Action Selection » qui inclut les ganglions de la base et le thalamus, le cortex préfrontal, un sous-système soutenant la mémoire de travail, etc.

Autre caractéristique fort intéressante de ce modèle sur laquelle nous reviendront à la séance 9, c’est cette similitude de forme entre l’objet réel perçu par la machine et sa représentation appelée « pointeur sémantique ». Un aspect, encore une fois, qui se rapproche probablement du fonctionnement de notre cerveau où plusieurs études montrent que les aires sensorielles et motrices peuvent être réactivées lors de l’évocation d’un souvenir ou d’un concept.

Finalement, au niveau moteur justement, la réponse du système n’est pas donnée simplement sur un écran d’ordinateur mais est extériorisée de façon motrice par un bras qui la dessine sur une feuille ! Voilà donc un système global, intégrant symbolisme, connexionnisme et surtout l’aspect incarné de la cognition.

Le découpage rapide que je viens d’évoquer insistant différemment sur les trois grands paradigmes des sciences cognitives ne peut évidemment pas rendre justice à la très grande diversité des travaux sur les architectures cognitives. À preuve, les approches dynamiques, dont je n’ai pas parlé ici mais dont on sait la complémentarité avec une conception incarnée de la cognition. Je vous réfère en cela à la partie où je présentais les concepts d’attracteurs, d’espace d’état, de trajectoire, de bifurcation et de chaos déterministe dans la séance 5 sur les rythmes cérébraux. Il s’agit donc d’un rejet assez radical des règles et des représentations au sens courant où la pensée sera représentée dans un espace multidimensionnel traversé par une trajectoire (qui est la pensée poursuivie par un agent…).

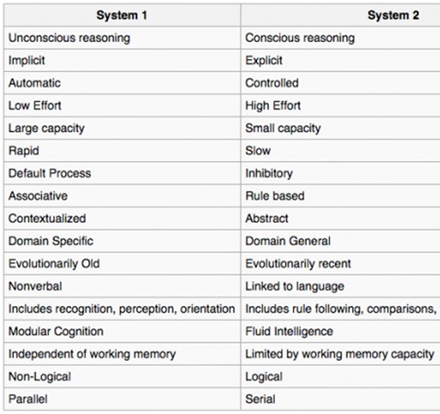

Je voudrais terminer en vous parlant non pas d’une approche encore plus récente, mais d’une très ancienne qui est pourtant encore d’actualité. Il s’agit de ce qu’on appelle les théories à processus duaux (« dual process theories ») ou encore les théories du double système. Ces systèmes proposent de distinguer deux grandes réponses cognitives chez un individu : l’une intuitive et rapide (qu’ils nomment « système 1 ») et l’autre logique, issue d’une délibération plus lente (qu’ils nomment « système 2 »).

J’ai gardé ceci pour la fin parce que ça introduit les travaux de Guillaume Beaulac qui va venir animer la 2e partie de la séance de mercredi et dont on peut voir ici la présentation autour de cette question qu’il avait donnée en juin dernier à l’école d’été sur le raisonnement de l’Instititut des sciences cognitives de l’UQAM.

Au fil des ans, on en est arrivé à une espèce de synthèses des propriétés que l’on attribue au deux grands systèmes de pensée, l’un rapide et intuitif qui aurait des origines évolutives les plus anciennes, et l’autre plus lent et réflexif, qui serait apparu plus récemment au cours de l’évolution.

Ces deux modes de pensée auraient chacun leurs avantages et leurs inconvénients.

Le premier, qualifié parfois aussi de « pensée heuristique », repose sur des croyances, des habitudes, des stéréotypes, des idées reçues depuis tout petit. Dans un monde complexe où l’on est submergé d’informations contradictoires de toutes sortes il est certainement plus confortable et opérationnel. Mais il biaise notre pensée en faveur de savoirs déjà acquis et nous empêche parfois de faire des distinctions importantes.

À l’opposé, la pensée dite « algorithmique » est logique, rationnelle, et elle procède par déductions, inférences et comparaisons. Plus lente et difficile d’accès, c’est toutefois grâce à elle que l’on peut sortir de la routine et des ornières de nos conditionnements et que l’on peut voir au-delà des apparences. C’est ainsi que l’on va pouvoir, avec un peu d’effort, aller comparer les programmes des différents partis lors d’une élection et voter pour celui qui nous rejoint le plus, plutôt que d’écouter seulement le débat des chefs et de voter pour la personne la plus charismatique…

En d’autres termes, le système 2 serait celui qui anime notre petite voix intérieure, celle qu’on associe à notre libre arbitre. Elle est toutefois constamment en pourparlers, souvent à notre insu, avec les processus inconscients du système 1 qui serait, selon plusieurs auteurs, le système dominant par défaut. C’est pourquoi nous serions si sujet à toutes sortes d’heuristique et de biais cognitifs qui s’expriment souvent sans même qu’on détecte les erreurs logiques qu’on est en train de commettre.

Un exemple simple chez l’enfant (mais il y en a bien d’autres chez l’adulte aussi) : devant deux rangées de jetons comportant l’une et l’autre le même nombre de jetons mais avec une rangée où ils sont plus espacés, un enfant va être tenté, avec son mode de pensée heuristique, de dire « qu’il y en a plus là où c’est plus long ». Vers l’âge de 6-7 ans cependant, l’enfant parvient à mettre entre parenthèses sa croyance spontanée pour examiner la situation au moyen de ses outils logiques. Il compte alors les jetons et il se rend compte que les deux rangées en comportent le même nombre.

Olivier Houdé, qui dirige un laboratoire de psychologie et de neurosciences à Paris, explique que pour accéder au système 2 dans moult de situations, on doit dans un premier temps bloquer le mode automatique du système 1 toujours prêt à s’exprimer. Impossible, donc, d’exercer sa pensée critique si l’on ne réussit pas, dans un premier temps, à faire taire cette première réponse rapide qui nous vient spontanément à l’esprit.

Ce que l’équipe de Houdé a donc mis en évidence, à la suite de plusieurs autres travaux qui vont en ce sens, c’est ni plus ni moins qu’un « système 3 », un système inhibiteur du système 1. Il correspond à des réseaux de neurones impliquant notre cortex préfrontal inférieur capable d’inhiber d’autres zones du cerveau impliquées dans ces automatismes de pensée (Houdé parle du sillon intrapariétal latéral, par exemple).

Ce serait donc ce type de câblage inhibiteur que l’on active lors du test des jetons présenté plus haut ou encore lorsqu’on doit choisir entre une pomme ou d’un gâteau au chocolat pour dessert. Si l’on réussit à activer suffisamment notre « système 3 », on optera finalement pour la pomme, ayant résisté courageusement (!) à notre instinct ancestral pour le sucre, fort utile dans notre passé de chasseur-cueilleur où les calories étaient rares, mais aujourd’hui néfastes pour la santé avec les tonnes de sucre raffiné facilement accessibles.

On voit donc une fois de plus comment perspective évolutive et plausibilité biologique peuvent faire évoluer des modèles psychologiques, même anciens.

Non classé | Comments Closed